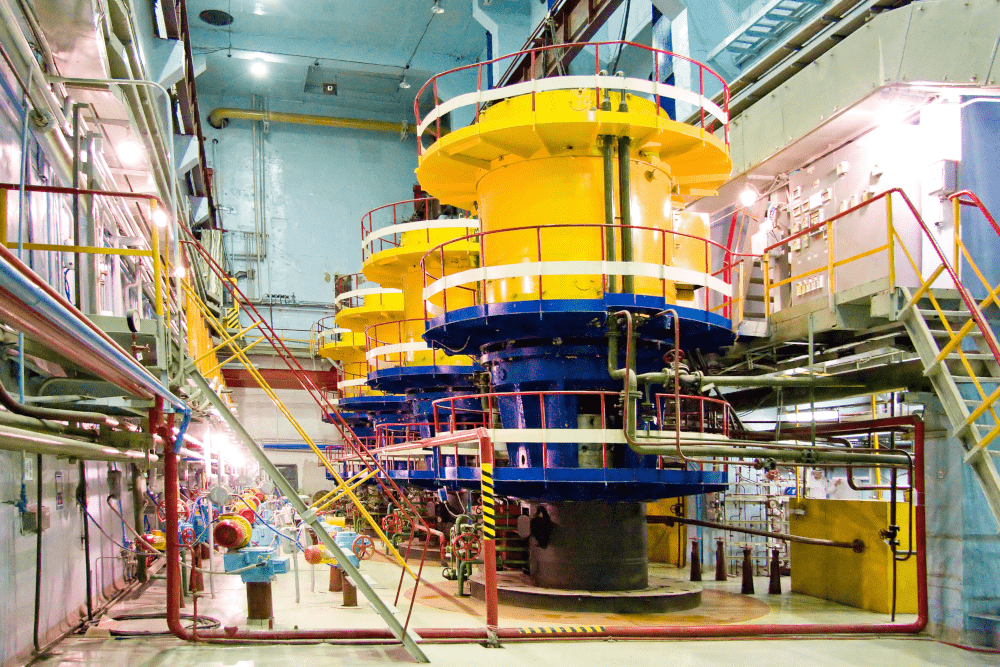

Специалисты Центра инженерно-физических расчетов и анализа выполнили пуско-наладочные работы и нагрузочное тестирование нового вычислительного кластера БГТУ «ВОЕНМЕХ» им. Д.Ф.Устинова (г. Санкт-Петербург), который будет использоваться для решения задач прикладной механики деформируемого твердого тела, вычислительной гидро- и газодинамики.

Высокопроизводительный вычислительный кластер создан на кафедре «Средства ВКО и ПВО» Балтийского государственного технического университета «ВОЕНМЕХ» им. Д.Ф. Устинова в рамках инфраструктурного проекта, ориентированного на укрепление кадрового потенциала российского ОПК, в частности, для целевого обучения студентов предприятий Санкт-Петербурга - АО «КБСМ» и АО «ГОЗ Обуховский завод». «ВОЕНМЕХ» получил в свое распоряжение данный высокопроизводительный вычислительный комплекс для численного моделирования физических процессов и проведения научных и инженерных расчетов с помощью программной системы ANSYS. Вычислительная система спроектирована и построена специалистами Центра инженерно-физических расчетов и анализа (АО "ЦИФРА") и компании Hewlett Packard Enterprise. С учетом лучших мировых практик система предоставляет возможности не только для выполнения высокопроизводительных расчетов в своем вычислительном ядре, но и обеспечивает удобную работу с полученными результатами без необходимости передавать большие объемы информации на рабочие станции пользователей.

Вычислительное ядро

Вычислительное ядро представляет собой кластер, построенный на базе платформы HP Apollo 6000 компании Hewlett Packard Enterprise. Данная платформа, пришедшая на замену заслуженной HP ProLiant SL6500 Scalable System, специально спроектирована для построения высокопроизводительных вычислительных систем (HPC, High Performance Computing).

Интерконнект

Когда речь заходит об HPC, то одним из основных факторов, обеспечивающих высокое быстродействие системы, является правильный выбор интерконнекта – специализированной сети, поддерживающей работу вычислительных алгоритмов с распределённой памятью. Для обеспечения работы Intel MPI и Platform MPI в данном проекте выбран интерконнект Mellanox Infiniband FDR, имеющий ширину канала 56 Гбит/с и задержки не более 1 микросекунды. Все узлы кластера имеют двойное подключение к интерконнекту, что позволяет добиться отказоустойчивости вычислительной сети или, при необходимости, существенно увеличить скорость работы системы благодаря технологии Infiniband Multi-Rail.

Когда речь заходит об HPC, то одним из основных факторов, обеспечивающих высокое быстродействие системы, является правильный выбор интерконнекта – специализированной сети, поддерживающей работу вычислительных алгоритмов с распределённой памятью. Для обеспечения работы Intel MPI и Platform MPI в данном проекте выбран интерконнект Mellanox Infiniband FDR, имеющий ширину канала 56 Гбит/с и задержки не более 1 микросекунды. Все узлы кластера имеют двойное подключение к интерконнекту, что позволяет добиться отказоустойчивости вычислительной сети или, при необходимости, существенно увеличить скорость работы системы благодаря технологии Infiniband Multi-Rail.

Графические процессоры

Современным вычислительным системам класса HPC недостаточно иметь быстрые центральные процессоры и хороший интерконнект. Обеспечить дополнительные ресурсы для параллельных вычислений позволяет установка во все узлы кластера графических процессоров общего назначения NVIDIA Tesla K80.

Современным вычислительным системам класса HPC недостаточно иметь быстрые центральные процессоры и хороший интерконнект. Обеспечить дополнительные ресурсы для параллельных вычислений позволяет установка во все узлы кластера графических процессоров общего назначения NVIDIA Tesla K80.

Дисковая подсистема

Высокопроизводительный вычислительный кластер должен обладать соответствующей дисковой подсистемой, способной вовремя записывать как промежуточные данные, так и результаты расчетов. Хранение результатов обеспечивается специализированной системой хранения данных (СХД). Однако, и ее производительности может не хватить для обслуживания всех вычислительных процессов во время выполнения расчетов. Обеспечить оптимальное быстродействие дисковой подсистемы призваны кэширующие твердотельные диски (SSD), установленные в каждом узле кластера. Кластер спроектирован как “бездисковый” – операционные системы узлов загружаются с управляющего узла сразу в память, минуя процедуру установки на локальные диски. Благодаря этому возможно использовать все ресурсы SSD для промежуточного кэширования результатов расчетов. Такая схема позволяет получить линейно масштабируемую систему ввода/вывода, не уступающую по быстродействию сложным параллельным файловым системам.

Система управления

Вычислительное ядро созданной HPC-системы основано на двух корневых системах промышленного уровня – HP Insight Cluster Management Utility и Altair PBS Pro.

HP Insight Cluster Management Utility (CMU) является фирменной системой управления кластерами от Hewlett Packard Enterprise. Она занимается развёртыванием операционных систем узлов, настройкой рабочего окружения для функционирования всех прочих программных систем, и, конечно же, производит постоянный мониторинг работы вычислительного комплекса.

Altair PBS Pro – вторая по важности корневая система вычислительного ядра – система управления очередью задач и менеджер загрузки кластера. PBS Pro на сегодняшний момент является одной из самых умных и гибких систем в своем классе. Синтаксис PBS запросов стал де-факто стандартом при планировании загрузки кластеров. PBS Pro способен взаимодействовать с HP CMU настолько тесно, что по запросу пользователя на выполнение специфического расчета PBS может поручить CMU полностью переустановить операционные системы некоторых вычислительных узлов.

Altair PBS Pro – вторая по важности корневая система вычислительного ядра – система управления очередью задач и менеджер загрузки кластера. PBS Pro на сегодняшний момент является одной из самых умных и гибких систем в своем классе. Синтаксис PBS запросов стал де-факто стандартом при планировании загрузки кластеров. PBS Pro способен взаимодействовать с HP CMU настолько тесно, что по запросу пользователя на выполнение специфического расчета PBS может поручить CMU полностью переустановить операционные системы некоторых вычислительных узлов.

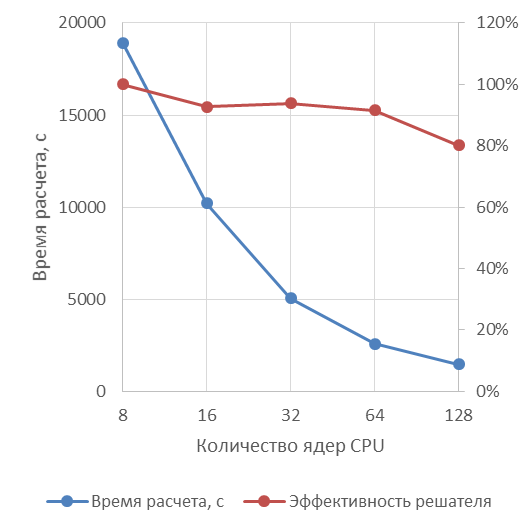

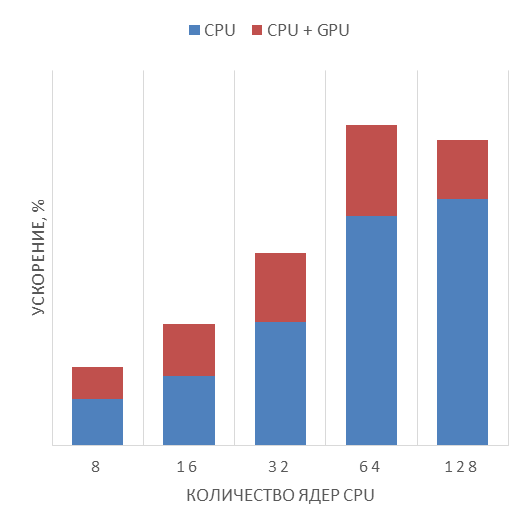

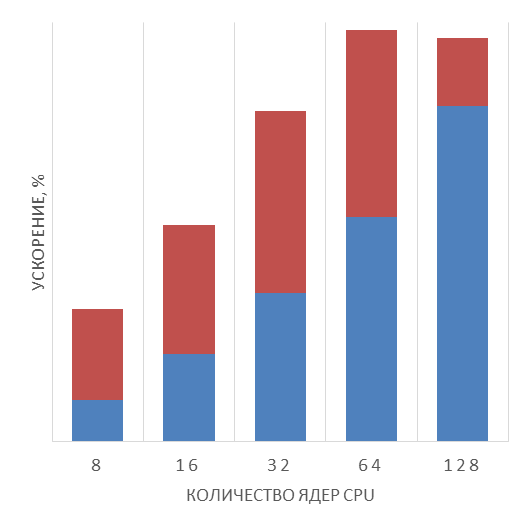

ANSYS Fluent: расчет реактивного двигателя, 12 миллионов полиэдральных ячеек, k-epsilon модель турбулентности

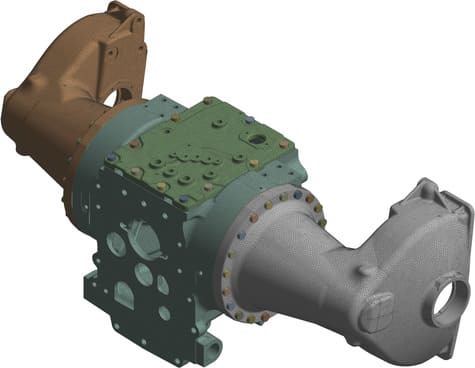

ANSYS Mechanical: линейная статическая прочность задней оси трактора, PCG, 12.3M уравнений

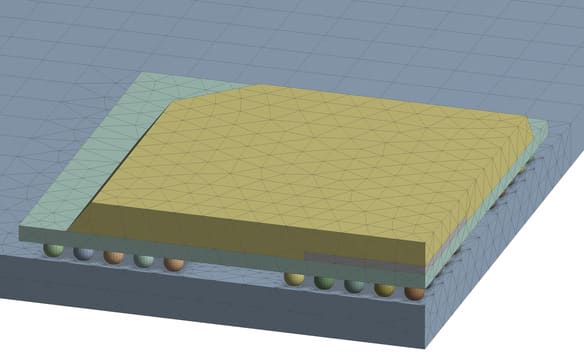

ANSYS Mechanical: нелинейная задача ползучести для BGA чипа, Sparce, 6.0M уравнений

Высокопроизводительные расчеты в ANSYS

Описанная выше инфраструктура высокопроизводительного кластера изначально спроектирована для выполнения расчетов в комплексе решателей ANSYS. Благодаря лицензии ANSYS Academic Multiphysics Campus Solution студенты и научные сотрудники БГТУ «ВОЕНМЕХ» им. Д.Ф.Устинова получили возможность выполнять расчеты в любой области физики и проводить многодисциплинарные исследования. Кластер построен таким образом, что обеспечивает высокую эффективность работы как МКЭ (метод конечных элементов) решателя задач механики ANSYS Mechanical, так и гидрогазодинамических (CFD, Computational Fluid Dynamics) кодов ANSYS Fluent и ANSYS CFX. Кроме того, для решения высоконелинейных динамических задач и моделирования быстропротекающих процессов имеется возможность использования ANSYS AUTODYN.

В рамках нагрузочного тестирования проведены тестовые расчеты, призванные продемонстрировать быстродействие системы. Первый из таких расчетов - расчет реактивного двигателя, модель которого содержит 12 миллионов полиэдральных ячеек. Расчет выполнен средствами ANSYS Fluent 17.0, используется k-epsilon модель турбулентности. Кроме гидродинамических расчетом в программу тестирования также вошли задачи механики. ANSYS Mechanical 17.0 показал отличные результаты при распараллеливании задач решаемых прямым и итерационным методом. Так, при расчете линейной статической прочности задней оси трактора итеративным решателем PCG, система показала ускорение на 30-40% при решении 12.3 миллионов уравнений. Для прямого решателя Sparce результаты расчета с использованием Tesla K80 оказались еще более внушительными: нелинейная задача ползучести для BGA-чипа, содержащая 6.0 миллионов уравнений, была решена 2 раза быстрее с использованием GPGPU.

Удаленная визуализация

Вычислительное ядро – это только часть нового вычислительного комплекса. Результаты расчетов на кластере могут оказаться слишком объемными для передачи на рабочие места пользователей. Поэтому, для удаленной обработки результатов вычислительная система оборудована специализированной инфраструктурой виртуальных рабочих столов (VDI) для работы с инженерной графикой. Специально спроектированная система для работы с CAD и CAE программным обеспечением сочетает в себе самые передовые технологии.

Удаленным рендерингом изображения занимаются сразу две видеокарты NVIDIA GRID K2. Работа гостевых виртуальных машин поддерживается технологиями, заложенными в гипервизор VMware vSphere ESXi – он позволяет использовать технологию NVIDIA vGPU для виртуализации и разделения ресурсов графических процессоров. В качестве системы доставки удалённых рабочих столов применяется программное обеспечение NICE Desktop Cloud Virtualisation (DCV).

Удаленным рендерингом изображения занимаются сразу две видеокарты NVIDIA GRID K2. Работа гостевых виртуальных машин поддерживается технологиями, заложенными в гипервизор VMware vSphere ESXi – он позволяет использовать технологию NVIDIA vGPU для виртуализации и разделения ресурсов графических процессоров. В качестве системы доставки удалённых рабочих столов применяется программное обеспечение NICE Desktop Cloud Virtualisation (DCV).

DCV ведет свою историю с 1994 года, и за это время стал де-факто стандартом для удаленной работы с инженерной графикой. Система доставки удаленных рабочих столов обеспечивает удаленную работу с графикой уровня OpenGL 4+ для Windows и Linux. При этом, собственный протокол передачи данных использует всего около 1 Мбит/с ширины канала доступа на работу одного Full HD монитора. Изюминкой протокола DCV является полностью аппаратное кодирование и декодирование потока данных на GPU, что положительно сказывается на быстродействии и времени реакции удаленной системы на манипуляции инженера. Столь низкие требования к пропускной способности канала, высокая скорость реакции и встроенное шифрования AES с 256-битным ключом позволяют удаленно работать с кластером практически с любого рабочего места, подключенного через глобальную сеть.

Дополнительные удобства при организации рабочей сессии предоставляет система диспетчеризации удаленных рабочих столов NICE EnginFrame. Она позволяет пользователям и администраторам контролировать рабочие сессии в удобном WEB интерфейсе.

.png)